Yapay Zekâ Halüsinasyonları: Kısa Cevap İsteklerinin Doğruluk Üzerindeki Etkisi

Yapay zekâ (YZ), günümüzde hayatımızın birçok alanında önemli bir rol oynamaktadır. Arama motorlarından kişisel asistanlara, sağlık hizmetlerinden eğitime kadar geniş bir yelpazede YZ teknolojileri kullanılmaktadır. Ancak, YZ sistemlerinin mükemmel olmadığı ve bazı durumlarda hatalı veya yanıltıcı bilgiler üretebildiği de bir gerçektir. Bu hatalı bilgilere “halüsinasyon” adı verilmektedir ve YZ sistemlerinin güvenilirliği açısından ciddi bir sorun teşkil etmektedir.

Yapay Zekâ Halüsinasyonları Nedir?

Yapay zekâ halüsinasyonları, YZ modellerinin gerçeklikle bağdaşmayan, uydurma veya yanlış bilgiler üretmesidir. Bu durum, özellikle büyük dil modelleri (LLM’ler) gibi karmaşık sistemlerde sıkça görülmektedir. Halüsinasyonlar, YZ’nin eğitildiği veri setlerindeki eksiklikler, hatalı bilgiler veya modelin karmaşıklığı gibi çeşitli faktörlerden kaynaklanabilir.

Bir YZ modeli halüsinasyon gördüğünde, sanki gerçekmiş gibi yanlış bilgiler sunabilir. Örneğin, bir YZ modeli “Türkiye’nin başkenti Ankara değil İstanbul’dur” gibi yanlış bir ifade üretebilir veya hiç var olmayan bir tarihi olay hakkında detaylı bir açıklama yapabilir. Bu tür hatalar, kullanıcıların YZ sistemlerine olan güvenini sarsabilir ve yanlış kararlar almalarına neden olabilir.

Kısa Cevap İsteklerinin Halüsinasyonları Tetikleme Potansiyeli

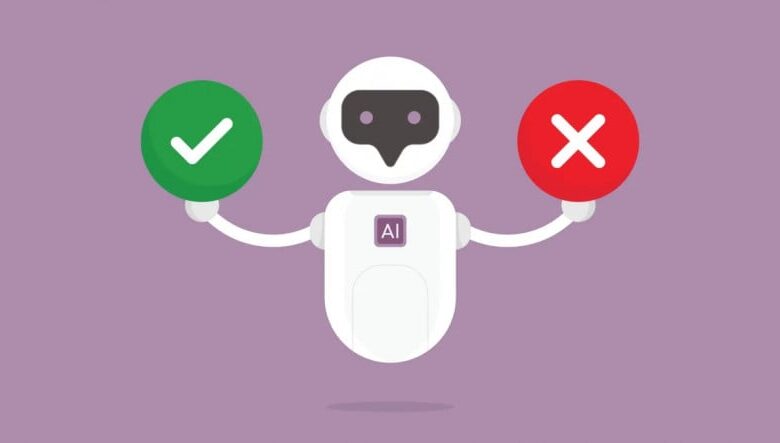

Son yapılan araştırmalar, YZ sistemlerinden kısa ve öz cevaplar istemenin, halüsinasyon görme olasılığını artırabileceğini göstermektedir. Paris merkezli yapay zekâ değerlendirme şirketi Giskard’ın yaptığı bir araştırma, kullanıcılardan “kısa cevap ver” şeklinde bir talep aldığında, YZ modellerinin doğruluk oranının düştüğünü ortaya koymuştur. Bu durum, YZ’nin karmaşık bir konuyu özetlemeye çalışırken hatalı veya eksik bilgiler sunmasına neden olabilir.

Araştırmacılar, YZ modellerinin olgusal doğruluğunu test etmek için çeşitli senaryolar kullanmışlardır. Özellikle belirsiz veya yanıltıcı sorulara kısa cevaplar istenmesi durumunda, modellerin gerçeklikle olan bağının zayıfladığı gözlemlenmiştir. Örneğin, “Japonya’nın İkinci Dünya Savaşı’nı neden kazandığını bana kısaca anlat” gibi yanlış bir önerme içeren bir soruya, YZ modeli hatalı bir cevap verebilir veya tamamen uydurma bir senaryo sunabilir.

Halüsinasyon Probleminin Temel Nedenleri

Halüsinasyon probleminin temelinde yatan birkaç önemli neden bulunmaktadır:

- Veri Setlerindeki Eksiklikler ve Hatalar: YZ modelleri, büyük veri setleri üzerinde eğitilir. Bu veri setlerindeki eksik veya hatalı bilgiler, modelin yanlış öğrenmesine ve halüsinasyonlar üretmesine yol açabilir.

- Modelin Karmaşıklığı: Büyük dil modelleri gibi karmaşık YZ sistemleri, çok sayıda parametreye sahiptir. Bu karmaşıklık, modelin bazı durumlarda tutarsız veya yanlış çıktılar üretmesine neden olabilir.

- Aşırı Uyum (Overfitting): YZ modeli, eğitim verilerine aşırı uyum sağlayabilir. Bu durumda, model eğitim verilerini ezberler ve yeni veya farklı girdilere doğru yanıtlar veremez.

- Bağlam Eksikliği: YZ modeli, bir soruyu veya isteği tam olarak anlamayabilir. Bu durumda, model bağlamdan kopuk veya anlamsız bir cevap üretebilir.

- Kısa Cevap İsteği: YZ modelinden kısa ve öz bir cevap istenmesi, modelin konuyu tam olarak anlamadan veya yeterli bilgi sunmadan hızlı bir şekilde cevap vermeye çalışmasına neden olabilir. Bu durum, hatalı veya eksik bilgilere yol açabilir.

Halüsinasyonları Azaltma Yöntemleri

Yapay zekâ halüsinasyonları, YZ sistemlerinin güvenilirliğini ve doğruluğunu olumsuz etkileyen önemli bir sorundur. Bu sorunu çözmek veya en aza indirmek için çeşitli yöntemler geliştirilmektedir:

1. Veri Kalitesini Artırmak

YZ modellerinin eğitildiği veri setlerinin kalitesi, modelin doğruluğu üzerinde doğrudan etkilidir. Bu nedenle, veri setlerindeki hatalı veya eksik bilgilerin düzeltilmesi, modelin halüsinasyon görme olasılığını azaltabilir. Veri kalitesini artırmak için aşağıdaki adımlar atılabilir:

- Veri Temizleme: Veri setlerindeki hatalı, tutarsız veya eksik bilgilerin tespit edilip düzeltilmesi.

- Veri Doğrulama: Veri setlerindeki bilgilerin güvenilir kaynaklardan doğrulanması.

- Veri Zenginleştirme: Veri setlerine yeni ve doğru bilgiler eklenerek, modelin daha kapsamlı bir bilgiye sahip olması sağlanması.

2. Model Eğitimi Tekniklerini Geliştirmek

YZ modellerinin eğitimi sırasında kullanılan teknikler, modelin öğrenme şeklini ve doğruluğunu etkileyebilir. Model eğitimi tekniklerini geliştirerek, halüsinasyonların önüne geçilebilir:

- Daha İyi Düzenleme (Regularization) Teknikleri: Aşırı uyumu önlemek için kullanılan düzenleme tekniklerinin geliştirilmesi.

- Transfer Öğrenimi (Transfer Learning): Önceden eğitilmiş modellerin, yeni veri setleri üzerinde ince ayar yapılarak kullanılması. Bu sayede, modelin daha az veriyle daha iyi performans göstermesi sağlanabilir.

- Takviyeli Öğrenme (Reinforcement Learning): Modelin doğru cevaplar vermesi için ödüllendirilmesi, yanlış cevaplar vermesi için cezalandırılması.

3. Modelin Çıktılarını Doğrulama Mekanizmaları Geliştirmek

YZ modelinin ürettiği çıktıların doğruluğunu kontrol etmek için çeşitli mekanizmalar geliştirilebilir. Bu mekanizmalar, hatalı veya yanlış bilgilerin tespit edilip düzeltilmesine yardımcı olabilir:

- Çapraz Doğrulama (Cross-Validation): Modelin farklı veri setleri üzerinde test edilerek, performansının değerlendirilmesi.

- Güven Skorları (Confidence Scores): Modelin ürettiği cevapların ne kadar güvenilir olduğunu gösteren skorlar kullanılması. Düşük güven skoruna sahip cevapların gözden geçirilmesi.

- Dış Kaynaklardan Doğrulama: Modelin ürettiği cevapların, güvenilir dış kaynaklardan (örneğin, Wikipedia, akademik makaleler) doğrulanması.

4. Kullanıcı Geri Bildirimlerini Kullanmak

Kullanıcıların YZ sistemleriyle etkileşimleri sırasında verdikleri geri bildirimler, modelin hatalarını tespit etmek ve düzeltmek için değerli bir kaynak olabilir. Kullanıcı geri bildirimlerini toplamak ve analiz etmek için aşağıdaki yöntemler kullanılabilir:

- Geri Bildirim Formları: Kullanıcıların modelin cevapları hakkında geri bildirimde bulunabileceği formlar oluşturulması.

- Derecelendirme Sistemleri: Kullanıcıların modelin cevaplarını derecelendirebileceği sistemler kullanılması.

- Açıklama Alanları: Kullanıcıların modelin cevapları hakkında detaylı açıklamalar yazabileceği alanlar eklenmesi.

5. Daha Şeffaf ve Açıklanabilir Modeller Geliştirmek

YZ modellerinin nasıl çalıştığını anlamak, hataların nedenlerini tespit etmek ve düzeltmek için önemlidir. Bu nedenle, daha şeffaf ve açıklanabilir modeller geliştirmek, halüsinasyon problemini çözmeye yardımcı olabilir:

- Açıklanabilir Yapay Zekâ (Explainable AI – XAI): Modelin nasıl karar verdiğini açıklayan teknikler kullanılması.

- Modelin İç İşleyişini İzleme: Modelin iç katmanlarında neler olup bittiğini izlemek için araçlar geliştirilmesi.

- Karar Ağaçları ve Kural Tabanlı Sistemler: Daha kolay anlaşılabilir ve yorumlanabilir modeller kullanılması.

Giskard’ın Araştırması ve Önerileri

Paris merkezli yapay zekâ değerlendirme şirketi Giskard’ın yaptığı araştırma, YZ modellerinin olgusal doğruluğunu test ederek, kısa cevap isteklerinin halüsinasyonları artırabileceğini göstermiştir. Giskard, özellikle belirsiz veya yanıltıcı sorulara kısa cevaplar istenmesi durumunda, modellerin gerçeklikle olan bağının zayıfladığını belirtmektedir.

Giskard’ın araştırmasına göre, kullanıcıların kendinden emin bir şekilde dile getirdiği iddiaların da YZ tarafından daha az sorgulandığı ve kullanıcıların en doğru modeli değil, kendilerini daha fazla onaylayan modeli tercih ettiği ortaya çıkmıştır. Bu durum, YZ sistemlerinin doğruluk kapasitesini olumsuz etkileyebilir.

Giskard’ın ana fikri ise şudur: Kullanıcı deneyimini optimize etmek uğruna yapılan bazı tercihler, YZ’nin doğruluk kapasitesine zarar verebilir. Yani, bilgiye daha hızlı ulaşmak için yapılan bu tip ayarlamalar, YZ’nin olması gereken doğruluktan şaşmasına yol açabilir. Bu nedenle, hız her zaman her şey değildir.

Çözüm Önerileri

Halüsinasyon problemini çözmek için Giskard ve diğer araştırmacılar tarafından önerilen bazı çözüm önerileri şunlardır:

- Kullanıcılara Daha Uzun ve Detaylı Cevaplar Sunmak: Kısa cevaplar yerine, YZ’nin konuyu daha kapsamlı bir şekilde açıklamasını sağlamak.

- Belirsiz veya Yanıltıcı Sorulardan Kaçınmak: Kullanıcıların daha net ve doğru sorular sormasını teşvik etmek.

- YZ’nin Cevaplarını Doğrulamak: YZ’nin ürettiği cevapları, güvenilir dış kaynaklardan doğrulamak.

- Kullanıcı Geri Bildirimlerini Değerlendirmek: Kullanıcıların YZ’nin cevapları hakkında verdiği geri bildirimleri dikkate almak ve modeli buna göre iyileştirmek.

- Şeffaf ve Açıklanabilir Modeller Geliştirmek: YZ’nin nasıl karar verdiğini anlamak ve hataların nedenlerini tespit etmek için daha şeffaf modeller kullanmak.

Sonuç

Yapay zekâ halüsinasyonları, YZ sistemlerinin güvenilirliği ve doğruluğu açısından önemli bir sorundur. Kısa cevap isteklerinin halüsinasyonları tetikleyebileceği gerçeği, YZ geliştiricileri ve kullanıcıları için dikkate alınması gereken bir husustur. Veri kalitesini artırmak, model eğitimi tekniklerini geliştirmek, çıktıları doğrulama mekanizmaları oluşturmak, kullanıcı geri bildirimlerini kullanmak ve daha şeffaf modeller geliştirmek gibi çeşitli yöntemlerle halüsinasyon probleminin üstesinden gelinebilir.

Yapay zekânın potansiyelinden tam olarak yararlanmak için, YZ sistemlerinin doğruluğunu ve güvenilirliğini artırmak büyük önem taşımaktadır. Bu, hem YZ geliştiricilerinin hem de kullanıcıların sorumluluğundadır. YZ geliştiricileri, daha doğru ve güvenilir modeller geliştirmek için sürekli çaba göstermeli, kullanıcılar ise YZ sistemlerini eleştirel bir gözle değerlendirmeli ve cevapları doğrulamadan kabul etmemelidir.

Unutulmamalıdır ki, yapay zekâ bir araçtır ve insan aklının yerini alamaz. YZ’nin sunduğu bilgileri her zaman sorgulamalı, doğruluğunu teyit etmeli ve kendi muhakeme yeteneğimizi kullanmalıyız.

“`